Apache Spark adalah framework open source untuk pemrosesan dan analisa data berskala besar. Spark menggunakan metode in-memory distributed processing, yaitu memanfaatkan sekumpulan komputer dan menggunakan memori utama (RAM) mereka untuk mendapatkan kinerja sebagaimana sebuah komputer besar yang powerful. Keunggulan ini membuat Spark menjadi framework yang sangat cepat dan ideal untuk aplikasi yang membutuhkan pemrosesan real-time dan analisis data interaktif.

Kelebihan Apache Spark

Beberapa kelebihan Spark adalah :

- Kecepatan : dengan memanfaatkan in-memory distributed computing, Spark dapat melakukan pemrosesan data dengan sangat cepat dan efisien. Untuk data yang relatif kecil, Spark dapat mencapai 100x lebih cepat dibanding Map Reduce pada Hadoop, dan untuk data besar Spark dapat mencapai 3 kali kecepatan Hadoop, dengan hanya memanfaatkan 1/10 dari mesin yang tersedia.

- Fleksibilitas dan kemudahan : Spark menyediakan API dalam berbagai bahasa pemrograman yang populer dalam pengolahan data seperti Python, Java, Scala, maupun R.

- Pemrosesan terpadu : Spark mendukung pemrosesan secara batch, streaming, real-time, dan analisis interaktif dalam satu framework.

- Skalabilitas : Kemampuan Spark dalam memproses data secara terdistribusi memungkinkan peningkatan kapasitas secara horizontal, untuk mengantisipasi volume data yang semakin besar seiring berjalannya waktu.

- Dukungan komunitas yang luas : Memiliki lebih dari 2000 kontributor, dan digunakan oleh banyak perusahaan, termasuk 80% perusahaan Fortune 500.

Fitur-Fitur Utama Apache Spark

- Pemrosesan Terdistribusi: Apache Spark menggunakan pemrosesan terdistribusi untuk memproses data. Ini berarti bahwa tugas-tugas pemrosesan dapat dipecah menjadi tugas yang lebih kecil dan dieksekusi secara paralel di beberapa mesin atau node dalam sebuah klaster. Dengan menggunakan pemrosesan terdistribusi, Spark dapat meningkatkan kecepatan dan efisiensi pemrosesan data.

- Komputasi In-Memory: Salah satu keunggulan utama Spark adalah kemampuannya dalam komputasi in-memory. Dengan memanfaatkan memori utama (RAM) untuk menyimpan data yang sedang diproses, Spark dapat mengakses data dengan cepat, mengurangi ketergantungan pada akses disk yang lebih lambat. Ini menghasilkan waktu respons yang lebih cepat dan kinerja yang lebih baik.

- Model Data Abstrak: Spark menyediakan model data abstrak yang disebut Resilient Distributed Datasets (RDD). RDD adalah kumpulan data yang terdistribusi dan tahan terhadap kesalahan. RDD dapat digunakan untuk menyimpan dan memanipulasi data dengan cara yang efisien, dan memungkinkan pengguna untuk melakukan operasi transformasi dan aksi pada data dengan mudah.

- Library Ekstensif: Apache Spark menyediakan library ekstensif yang mencakup berbagai fungsi dan algoritma untuk pemrosesan dan analisis data. Spark menyediakan library machine learning (MLlib) untuk membangun dan melatih model machine learning, library graph processing (GraphX) untuk analisis grafik, serta library pemrosesan stream (Spark Streaming) untuk memproses data secara real-time.

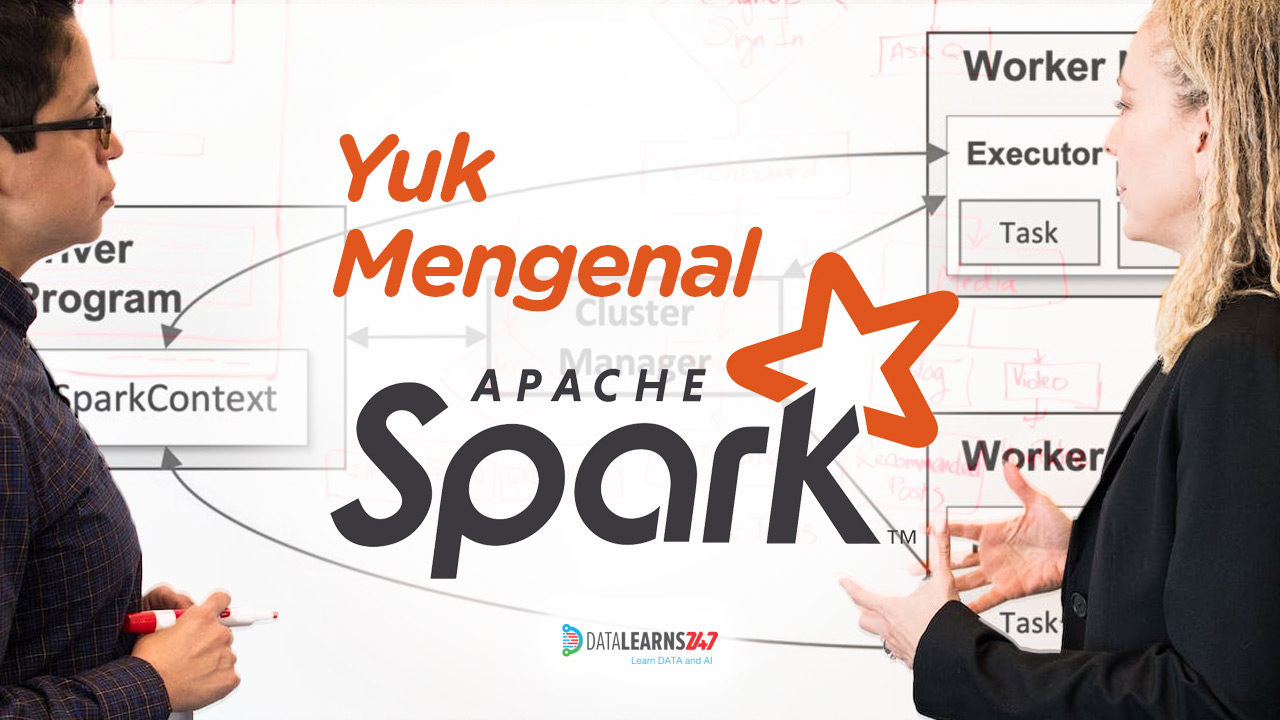

Arsitektur Apache Spark

Spark terdiri dari beberapa komponen utama, yaitu :

- Spark driver, yang merupakan proses utama dalam sebuah aplikasi Spark. Driver bertugas mengorkestrasikan pekerjaan pengolahan data. Driver menyimpan informasi tentang aplikasi, memecah tugas menjadi tugas yang lebih kecil (task), dan mendistribusikannya ke executor.

- Executor, yaitu proses-proses yang berjalan pada node dalam klaster Spark. Executor bertanggung jawab untuk menjalankan tugas-tugas yang diberikan oleh driver, mengelola alokasi memori, dan melaporkan status eksekusi pekerjaan ke driver.

- Cluster Manager, bertugas mengelola sumber daya komputasi dalam klaster Spark. Beberapa cluster manager yang populer adalah Kubernetes, Apache Mesos, Hadoop YARN, dan Spark Standalone. Cluster manager memastikan efisiensi alokasi sumber daya komputasi, seperti CPU dan memori, kepada aplikasi Spark yang berjalan di cluster.

Komponen Spark

Spark memiliki banyak library dan API (application programming interface) tingkat tinggi untuk berbagai keperluan pengolahan, analisis, dan pemanfaatan data.

Secara garis besar, komponen Spark terbagi dalam 3 layer, yaitu :

- Lower level API : merupakan API tingkat rendah yang termasuk ke dalam Spark core. Komponen utama API ini adalah RDD (Resilient Distributed Dataset) yang merupakan abstraksi dasar Spark. Structured API dibangun di atas RDD, dan akan dikompail menjadi operasi RDD yang efisien oleh Spark optimizer.

- Structured API : API Terstruktur adalah sekumpulan library untuk memanipulasi berbagai jenis data, mulai dari file log tidak terstruktur, file CSV semi terstruktur, hingga file Parquet yang terstruktur. Terdapat tiga jenis API di level ini, yaitu : Dataset, DataFrame, dan SQL table dan view.

- Spark libraries & ecosystem : berbagai pustaka pengolahan dan pemanfaatan data yang dibangun di atas Structured API, diantaranya yaitu advanced analytics, machine learning, deep learning, structured streaming, dan lain sebagainya.

Apache Spark telah menjadi pilihan yang populer bagi para profesional di bidang pemrosesan dan analisa big data. Dengan keunggulan seperti pemrosesan terdistribusi, komputasi in-memory, model data abstrak, dan library ekstensif, Spark merupakan solusi yang efisien dan efektif dalam pemrosesan dan analisa data yang kompleks. Kecepatan dan skalabilitasnya, Apache Spark memberikan perubahan dalam cara kita memproses dan menganalisa big data, serta memberikan insight berharga yang dapat membantu perusahaan dan organisasi dalam pengambilan keputusan yang lebih cerdas.